Зачем вообще обновлять API для аутентификации

Если кратко, старые схемы входа «логин‑пароль и куки» больше не тянут реальный интернет. Боты, фишинг, утечки баз — всё это бьёт именно по уязвимым точкам авторизации. Когда вы обновляете API для входа, вы не просто добавляете галочку «современно», а снижаете риск взлома, облегчаете жизнь разработчикам и поднимаете доверие пользователей. Безопасная аутентификация на сайте API сегодня — это не опция, а способ остаться в живых в конкурентной и довольно токсичной цифровой среде.

Классика: сессии и куки — почему уже не хватает

Исторически всё держалось на сессиях в базе и сессионных cookie. Пользователь логинится, сервер создаёт запись, отдаёт идентификатор, браузер хранит его в cookie и подставляет при каждом запросе. Подход всё ещё рабочий, но плохо масштабируется в микросервисах, неудобен для мобильных клиентов и уязвим при XSS и краже cookie. Чтобы сделать его приемлемым, приходится прикручивать HttpOnly, SameSite, шифрование, отдельное хранилище сессий, а это уже превращает «простое» решение в хрупкую и сложную конструкцию.

Когда всё ещё можно оставить сессии

У традиционной модели есть плюс: простота для небольших проектов, где один бекенд, нет мобильного приложения и ограниченный трафик. Там сессии выигрывают у сложных протоколов по времени внедрения и порогу входа для новичков. Но как только появляется идея разбить монолит на сервисы, добавить SPA на фронтенде или открыть публичное API, простая сессионная схема начинает тормозить и по безопасности, и по архитектуре. В этот момент стоит задуматься, не проще ли один раз перейти на современную модель токенов и уже от неё отталкиваться.

JWT и токены: удобно, но с подводными камнями

JSON Web Token сделал авторизацию в API популярной: всё зашито в компактный токен, серверу не нужно хранить состояние, а микросервисы проверяют подпись и спокойно доверяют данным. Однако именно здесь новички часто стреляют себе в ногу: делают бесконечный срок жизни токена, хранят его в localStorage, забывают про отзыв, выбирают слабый алгоритм. В результате взлом одного устройства превращается в длительный несанкционированный доступ, а лог-аут превращается в иллюзию, потому что старый токен всё ещё работает.

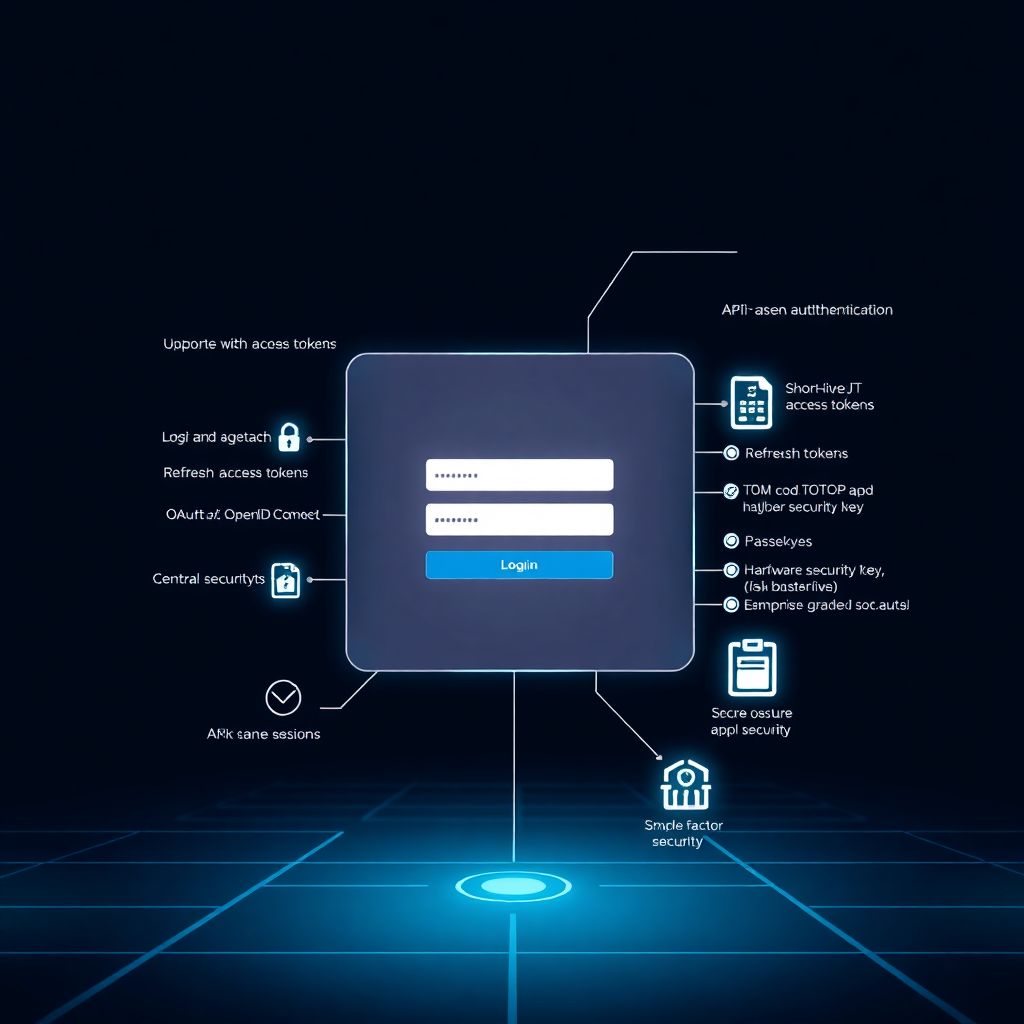

Как использовать токены безопасно

Разумный компромисс — короткоживущие access-токены плюс refresh-токены с более жёстким контролем. Access хранится в памяти приложения или защищённом cookie, refresh — только по защищённому каналу и с привязкой к устройству. Ошибка новичков — пытаться «зашить всё» в один вечный JWT вместо нормального механизма обновления. При переходе на такую схему обновление протоколов безопасности и аутентификации для веб-сайта становится управляемым: вы можете централизованно отзывать refresh и жёстко ограничивать время риска при компрометации access-токена.

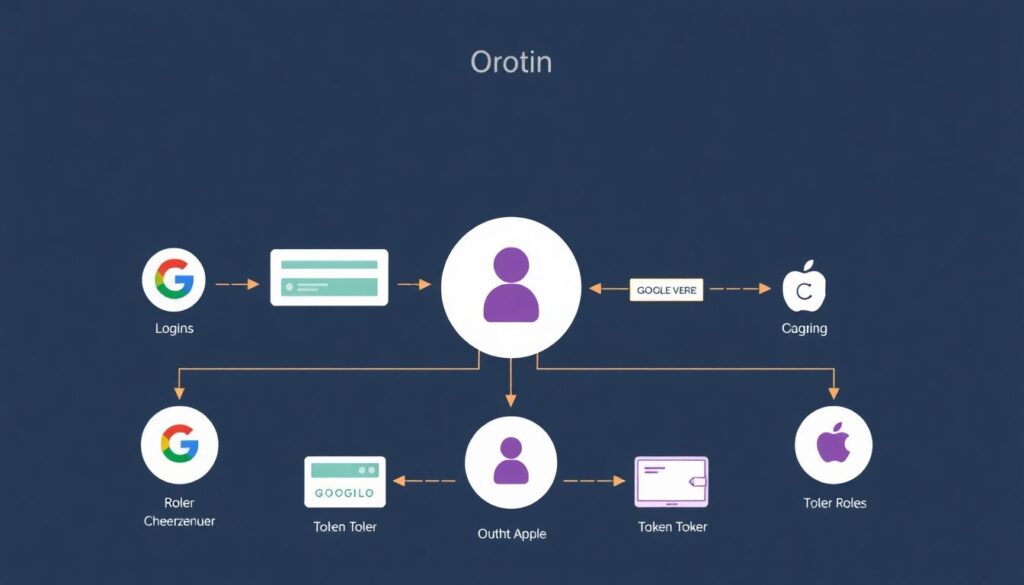

OAuth2 и OpenID Connect: стандарт вместо самоделок

Когда требуется логин через Google, Apple или единый вход между несколькими вашими сервисами, на сцену выходит OAuth2 и его надстройка OpenID Connect. В отличие от самописных схем, здесь чётко описаны роли, потоки, форматы токенов, и это удобно для интеграции с внешними системами. Для бизнеса, который не хочет разбираться в спецификациях, вариант «oauth2 авторизация для сайта купить решение» выглядит вполне рационально: готовые провайдеры берут на себя и хранение секретов, и обновление шифров, и мониторинг атак. Но за это, разумеется, платят и деньгами, и зависимостью от внешней платформы.

Самостоятельный развёртывание против готовых сервисов

Свой OAuth2/OpenID Connect-сервер — это полный контроль, гибкая настройка и отсутствие внешних подписок, но и ответственность за безопасность целиком на вас. Обновлять библиотеки, шифрование, протоколы придётся регулярно и без права на ошибку. Готовое API для авторизации пользователей на сайте, будь то коммерческий сервис или open-source решение в управляемом облаке, снимает часть головной боли: авторизация становится «чёрным ящиком» с понятным SDK и документацией. Компромисс простой: больше своей работы и контроля или меньше усилий, но с доверением чужой инфраструктуре.

Двухфакторная и многофакторная аутентификация

Даже самое аккуратное хранение паролей не спасает, если пользователь сам их отдаёт фишинговому сайту. Поэтому внедрение двухфакторной аутентификации через API стало нормой: код по SMS, push‑уведомление, приложение‑генератор (TOTP), аппаратный ключ. С точки зрения API это ещё один шаг в цепочке входа, который можно настраивать по рискам: новый браузер, необычное местоположение, попытка изменить пароль — включаем дополнительную проверку. Чисто «парольный» вход всё чаще воспринимается как временный компромисс, а не целевой вариант.

Что выбрать для 2FA на практике

SMS объективно слабы по безопасности, но просты по UX; TOTP‑приложения и push‑аппы лучше защищают, но требуют установки и грамотной реализации на бекенде. Самый надёжный подход — FIDO2/WebAuthn и аппаратные ключи или passkeys, но для массовых сайтов это пока скорее дополнительный слой. Для новичков важен постепенный переход: сначала добавить TOTP или push в существующий API, затем продумать сценарии принудительного включения 2FA для администраторов, модераторов и других критичных ролей, где компрометация аккаунта особенно болезненна.

Пошаговый план обновления API аутентификации

Чтобы не утонуть в теории, удобно двигаться по понятному чек‑листу. Ниже — один из практичных маршрутов модернизации:

— Провести аудит текущей схемы входа, хранения паролей, токенов и логики выхода

— Выбрать целевую модель: сессии + 2FA, токены + OAuth2, или гибрид с внешним провайдером

— Обновить криптобиблиотеки, алгоритмы хеширования и протокола TLS на сервере

— Спроектировать контракт API: эндпоинты логина, обновления токенов, логаута, восстановления доступа

— Добавить многофакторную защиту и риск‑ориентированную проверку (новое устройство, странный IP)

— Настроить мониторинг неудачных попыток и аномальной активности, чтобы раньше замечать атаки

Типичные ошибки и как их избежать

Самые заметные промахи разработчиков лежат на поверхности: хранение паролей в виде простого хеша без соли, использование устаревших алгоритмов вроде MD5 или SHA‑1, крайне длинный срок жизни токенов, отсутствие механизма их отзыва. Ещё одна распространённая проблема — некорректная обработка ошибок авторизации: API возвращает слишком подробные сообщения, по которым злоумышленник может узнать, существует ли пользователь и как устроена система. В итоге все меры безопасности обнуляются не «крутым взломом», а цепочкой мелких недосмотров и спешки при релизах.

Предупреждения для новичков

Новым разработчикам легко переоценить себя и недооценить атакующих. Простой совет: не пытайтесь изобретать свой протокол или «улучшать» стандарты без глубокого понимания. Используйте готовые библиотеки и проверенные фреймворки, включайте строгие настройки по умолчанию, а не «на время разработки». Регулярно пересматривайте конфигурацию: по мере роста проекта будут появляться новые клиенты, мобильные приложения, интеграции, и каждая из них даёт дополнительную точку атаки, которую нужно осмысленно вписать в общую архитектуру безопасности.

Практичные советы по выбору подхода

Если у вас небольшой сайт без сложной архитектуры, то усиленная сессионная модель плюс 2FA — нормальный старт: быстро, понятно и с приемлемой защитой. Для проектов с API, мобильными клиентами и партнёрскими интеграциями лучше сразу внедрять токен‑ориентированную схему и продумать вперёд возможный переход на OAuth2/OpenID. В корпоративных сценариях, где есть бюджет и строгие требования, логично рассматривать и готовые сервисы, и профессиональные продукты, чтобы не держать всё на одном «герой‑разработчике», который отвечает за безопасность в одиночку.

Итог: не одно решение, а эволюция

Нет универсального ответа, «как правильно» сделать безопасную аутентификацию: это всегда баланс рисков, бюджета и зрелости команды. На раннем этапе достаточно аккуратно настроенной сессии, затем в игру входят токены, 2FA, и, наконец, полноправный OAuth2/OpenID с внешними провайдерами и безпарольными методами. Важно другое: регулярно пересматривать свои механизмы входа, проводить обновление протоколов безопасности и аутентификации для веб-сайта и не стесняться использовать внешние, хорошо отлаженные решения там, где собственных ресурсов на безопасность откровенно не хватает.